鱼羊 发自 凹非寺

量子位 报道 | 公众号 QbitAI

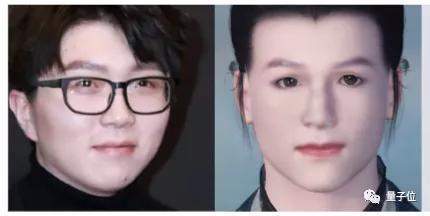

给AI一张毛不易的照片,它自动就能生成一个古风毛大侠。

小姐姐冷艳的气质,可以被还原出一代侠女风范。

也可以探索一下,奥巴马穿越回宋朝是一种怎样的体验……

现在,想在游戏里定制化自己的脸,你可以不用自己花时间琢磨参数了。

熟悉游戏的小伙伴可能认出来了,这一套AI捏脸术,来自网易伏羲人工智能实验室和密歇根大学。

现在,最新相关研究登上了AAAI 2021。

据作者介绍,这个名为MeInGame的方法,可以集成到大多数现有的3D游戏中,并且相比于单纯基于3DMM(3D Morphable Face Model )的方法,成本更低,泛化性能更好。

具体实现细节,一起来看。

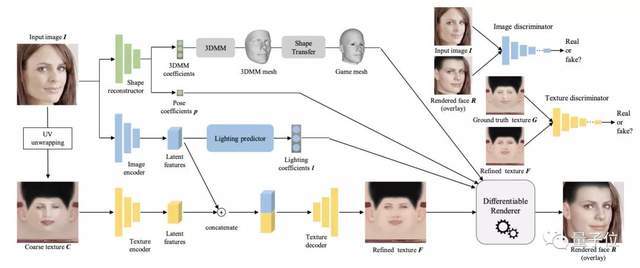

方法原理

研究人员将人脸形状和纹理的重建,视作一个自监督的面部相似度测量问题。

首先,对于输入照片,预先训练好的形状重建器会预测其3DMM和姿势系数,并在保持拓扑结果的同时,将3DMM网格转换成游戏网格。

这么做的原因,是3DMM网格的拓扑结构与大多数游戏中使用的网格不同。直接基于3DMM来从单张图像中还原出游戏中的3D人脸,需要大量的人脸纹理数据进行训练,费时费力不说,实验室条件下收集的数据也可能出现泛化不佳的问题。

接着,基于游戏网格,将输入图像解包到UV空间,创建一个粗纹理图。纹理会由一组编码器-解码器模块进行进一步细化。

另外,研究人员还设计了光照归回器。这是一个轻量级网络,由几个完全连接层组成,能根据图像特征预测光照方向、环境光、漫反射、高光等光照系数。

最后,将预测出的形状、纹理和光照系数一起反馈给可微分渲染器,在结果与输入的人脸照片相似的情况下,驱动2D人脸渲染。

研究人员还引入了两个判别器,来进一步改善结果。

具体到数据集的准备方面,这项研究提出了一种低成本面部纹理采集方法:与其他需要多视角图像的方法不同,只使用单视角图像,因此更加容易获取。

步骤如下:

对于输入的人脸图像,使用预训练人脸分割网络检测皮肤区域;

计算输入人脸皮肤的颜色均值,并将均值迁移到模板纹理图(由游戏开发者提供);

根据游戏网格,将输入的人脸图像进行解包到UV空间。

使用泊松混合,将解包后的图像与模板纹理图进行融合。移除头发、眼镜等非皮肤区域,并尽可能利用对称性补齐遮挡区域。

实验结果

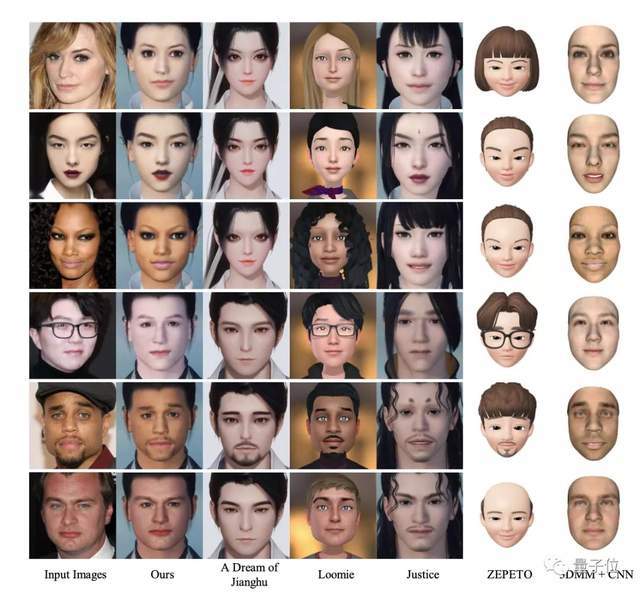

所以,网易伏羲实验室&密歇根大学的MeInGame,跟前辈方法们相比有何优势?

从与A Dream of AI、Loomie、ZEPETO等方法的定性比较结果来看,该方法无论是在面容(包括肤色)的还原度上,还是妆面这样的个性化细节上,都要略胜一筹,并且能消除光照和遮挡的影响。

而基于3DMM的方法虽然能够高度还原真实人脸,但其建模不包括完整的头部模型及纹理,很难直接用于游戏环境。

根据论文信息,相关代码和数据集,将会在GitHub上释出。

― 完 ―